Learning Memory-guided Normality for Anomaly Detection

单位:Yonsei University

会议:CVPR 2020

论文地址:Learning Memory-guided Normality for Anomaly Detection

代码地址:https://github.com/cvlab-yonsei/MNAD

基于CNN方法的一个缺点就是没有考虑正常样本的多样性,CNNs的能力太强,对于输入是异常的视频帧样本,也能重建的像异常视频帧,从而导致重建误差较小,无法区分异常数据。另一个缺点是没法直接检测异常而是通过重构损失或者预测未来帧的方式。为了克服这个问题,Deep SVDD通过将正常数据映射到紧凑的超球面而将异常数据映射的远离。但这种方法只有一个球面中心表征了全部正常数据,而没有考虑正常样本的多样性。

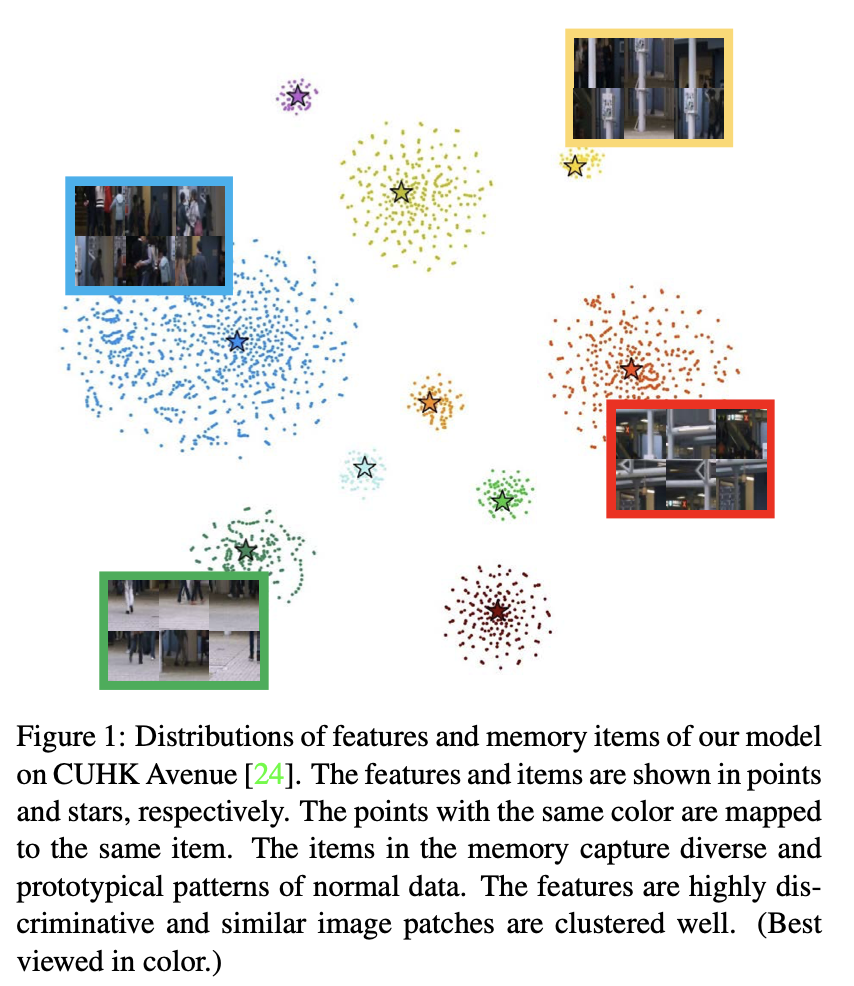

为了解决上述问题,提出了一种无监督学习的异常检测方法,使用具有更新方案的内存模块,其中内存中的记忆项记录正常数据的模式,考虑了正常模式的多样性,同时降低了CNN的表示能力。还提出了特征紧凑性和分离性损失,保证了记忆项的多样性,增强了记忆项的辨别能力。

创新

- 提出了一个无监督的异常检测学习方法,考虑了正常样本的多样性同时限制CNN表达能力

使用一个带更新方案的内存模块,其中记录着正常数据的模式。

提出了特征紧凑性损失(novel feature compactness)和分离性损失(separateness losses),保证记忆项的多样性和辨别能力。

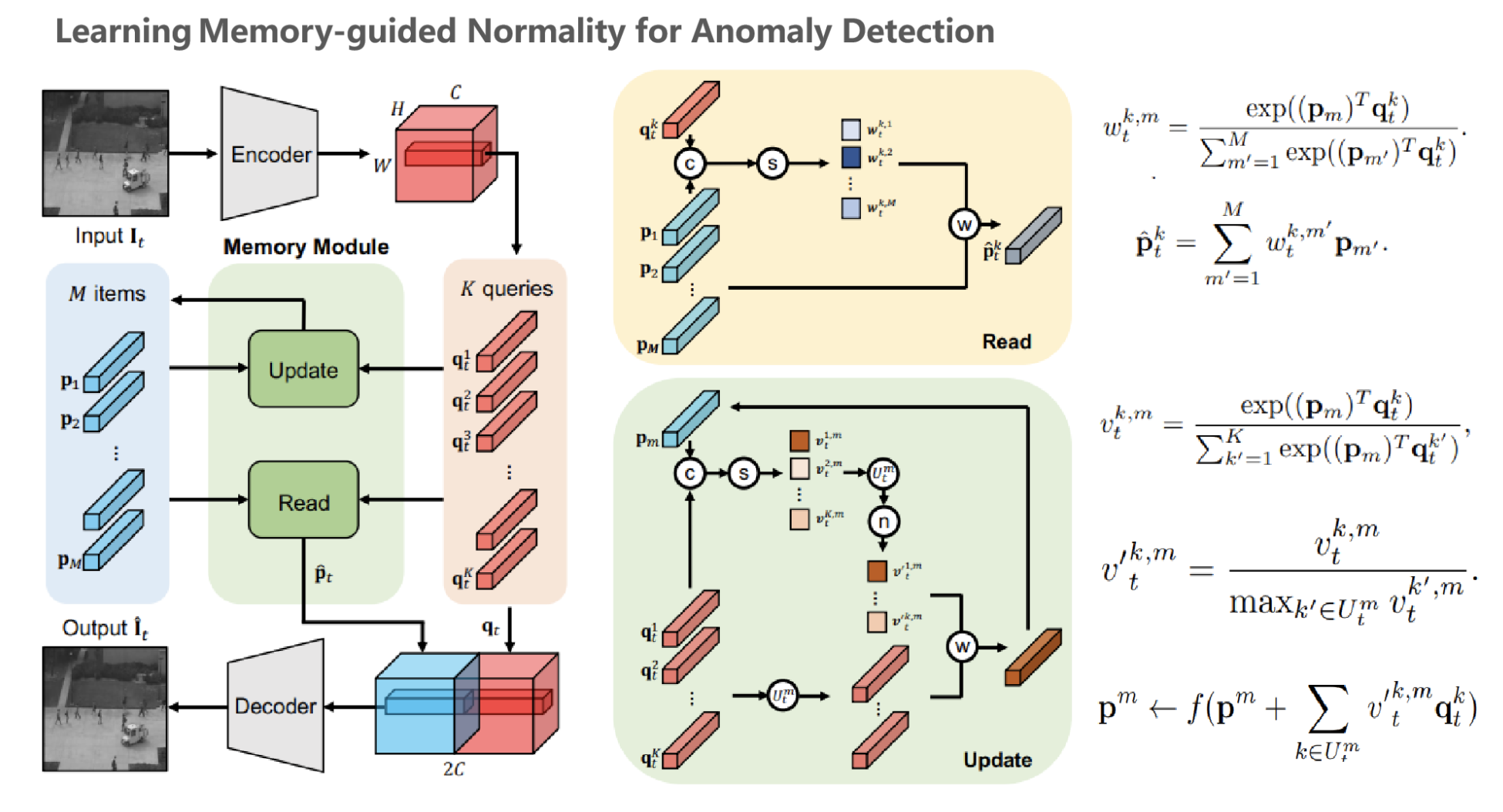

模型

该模型由Encoder、Decoder和一个Memory Module构成。关于Encoder和Decoder模块,文中选择U-Net模型,并在其基础上进行了修改。记忆模块包含M个记忆项,包含读和更新操作,用来记录正常数据的模式

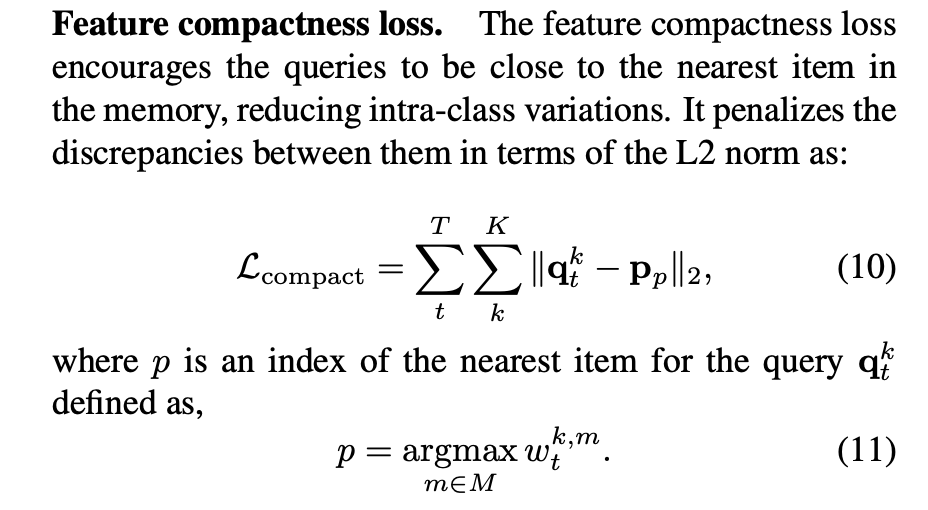

为了减少CNN特征的类内距离,提出了一种特征紧凑性损失,将正常视频帧的特征映射到记忆中最近的项,并使得它们靠近。

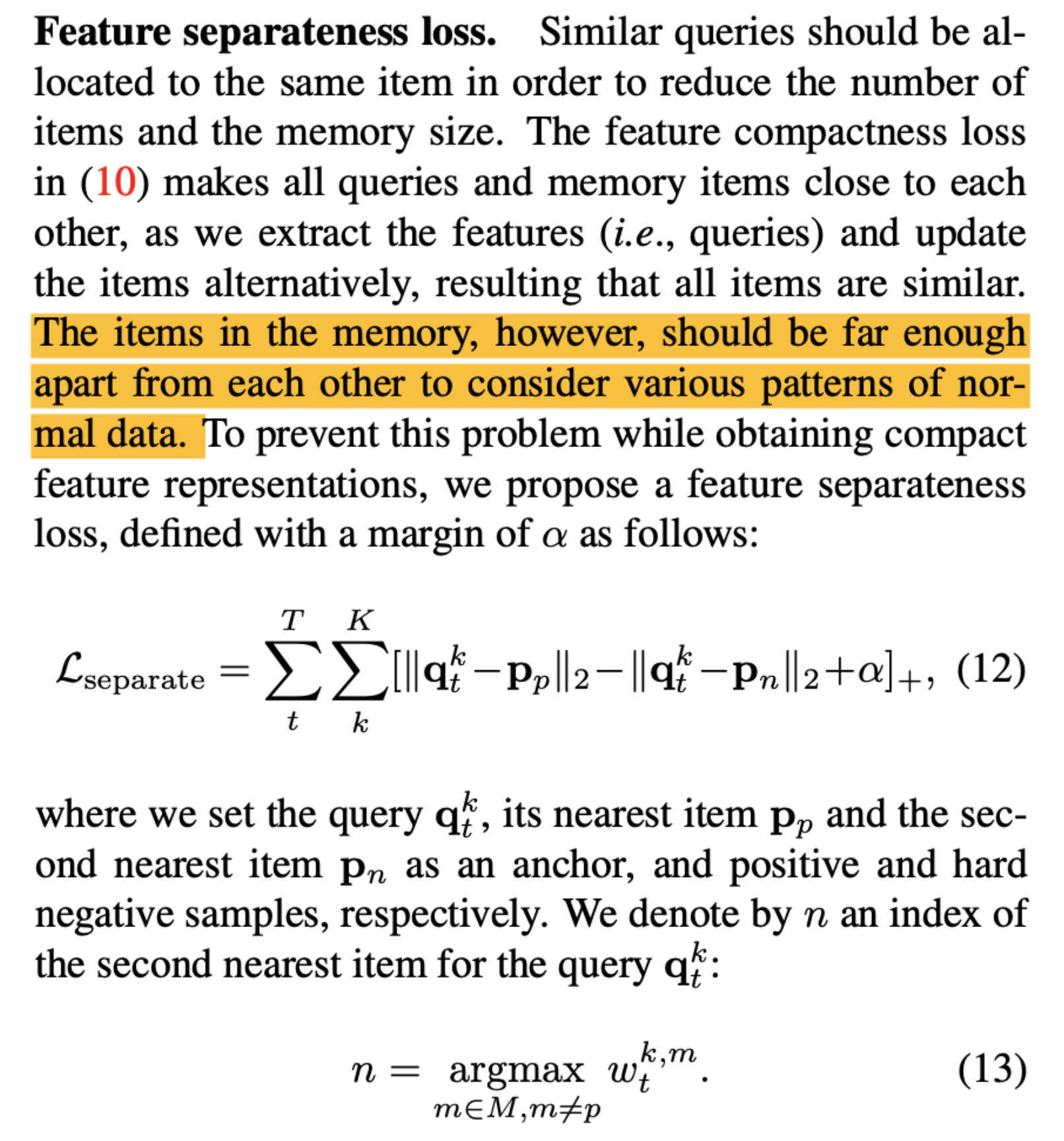

提出了特征分离损失,最小化了每个特征与其最近项之间的距离,同时最大化了特征与第二最近项之间的差异,增大类间距离,增强了特征和记忆项的分辨能力。

引入了一种更新策略,可以在测试时更新正常样本的记忆项

相比MemAE

MemAE利用3D Conv AE检索记录正常模式的相关记忆项,这些记忆项仅在训练期间更新。

本文通过使用特征紧凑性和分离性损失明确分离记忆项,记录不同的有区别的正常模式,与MemAE相比,记忆项(10 v.s. 2000)更少,并且能在测试时识别异常并更新记忆项,这使得模型也能记忆测试数据的正常模式,同时该模型推理速度更快67 fps,而MemAE为45 fps。

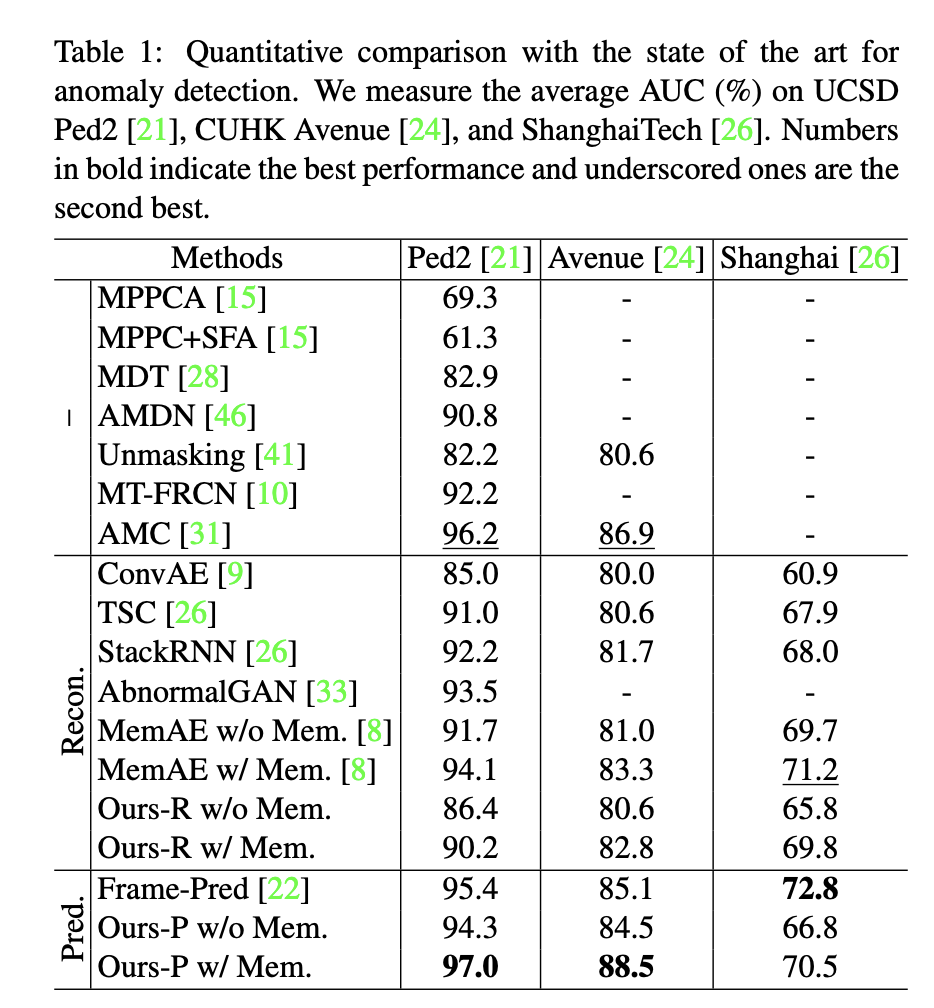

实验

在Ped2、CUHK以及ShanghaiTech数据集上的效果如下